Articolo originariamente pubblicato su ThinkinPark.

Donald Rumsfeld, con la celebre conferenza stampa del 2002, ha reso popolare lo schema di ragionamento basato sui concetti di “known unknowns” e “unknown unknowns”.

Il 12 febbraio 2002, il ministro della difesa degli Stati Uniti Donald Rumsfeld, durante una conferenza stampa sulla guerra in Iraq, fece un’affermazione piuttosto criptica in risposta ai giornalisti che gli chiedevano perché non fossero state trovate armi di distruzione di massa. La sua risposta fu la seguente:

“I rapporti che affermano che qualcosa non è accaduto hanno sempre attirato la mia attenzione, perché è risaputo, ci sono cose che sappiamo di sapere (“known knowns”). Ma sappiamo anche che ci sono cose che sappiamo di non sapere (“known unknowns”). Ma ci sono anche cose che non sappiamo di non sapere (“unknown unknowns”). E se si guarda alla storia del nostro paese e degli altri paesi liberi, è quest’ultima categoria di eventi che risulta la più difficile”.

Il discorso è ovviamente diventato subito virale (puoi vedere il video a questo link): all’inizio i giornalisti pensarono che Rumsfeld avesse utilizzato un giochetto di parole per sviare l’attenzione e non rispondere direttamente ad una domanda scomoda. Tuttavia con il tempo si capì che dietro al discorso apparentemente strano del ministro della Difesa ci fosse una filosofia di ragionamento ben precisa.

Quello che sappiamo di non sapere e non sappiamo di non sapere

Lo schema adottato da Rumsfeld era già piuttosto noto nella filosofia della scienza. Nel 1992 lo studioso Henry Bauer definiva i “known unknows” come eventi, che seppur difficilmente prevedibili e potenzialmente ad alto impatto, possono essere spiegati sulla base dei modelli teorici esistenti e dell’attuale stato della conoscenza. Al contrario gli “unknown unknowns” sono fenomeni che non possono essere interpretabili con i modelli esistenti e quindi oltre ad essere praticamente impossibili da prevedere sono anche di difficile comprensione.

La scienza e la conoscenza procedono solitamente per piccoli passi incrementali, attraverso una progressiva evoluzione delle teorie esistenti: quando si analizzano i dati relativi ad un fenomeno si tende sempre ad utilizzare un modello interpretativo già in uso. Per questo motivo quando accadono eventi che non sapevamo di non conoscere il nostro processo di comprensione va in tilt: i nostri vecchi modelli non funzionano più e dobbiamo svilupparne dei nuovi. Tendiamo a negare la nuova evidenza perché non spiegabile con la vecchia conoscenza. Le teorie, seppur con qualche resistenza iniziale, devono infine compiere un difficile salto in avanti che ci apre un nuovo orizzonte di comprensione.

La storia è piena di questi momenti in cui “unknown unknowns” costringono la conoscenza a procedere per salti (“leaps”). Così è stato per l’ossigeno: almeno tre chimici furono in grado di produrlo prima che la sua scoperta fosse universalmente accettata: fu infatti inizialmente classificato tra i gas già esistenti (utilizzo vecchi modelli). Lo stesso per i pianeti: Urano e Nettuno erano già stati individuati più volte da diversi osservatori prima di essere riconosciuti come “nuovi pianeti”. E così per i raggi X: dalla prima osservazione al riconoscimento scientifico passò oltre un secolo.

Un caso storicamente controverso è quello relativo ai meteoriti. Nonostante le numerose osservazioni di enormi crateri sul suolo terrestre, per secoli si è rifiutata l’ipotesi che rocce con diametro di alcuni chilometri potessero cadere dal cielo e colpire la terra. Oggi uno dei programmi più importanti della Nasa ha come obiettivo quello di sviluppare strategie per impedire o deviare la traiettoria di meteoriti che potrebbero colpire il suolo terrestre.

Le due forme di incertezza

Quello che sappiamo di non sapere (known unknowns) sono eventi che Nassim Taleb nel suo libro Il cigno nero definisce come “cigni grigi”: fenomeni riconducibili al concetto di rischio inteso come casualità gestibile (in francese hasard, dall’arabo az-zahr). Si tratta di eventi comprensibili attraverso i modelli esistenti, di cui non possiamo calcolare con accuratezza la probabilità ma siamo spesso in grado di valutarne le conseguenze, per cui possono essere oggetto di tecniche di risk management.

La pandemia Covid del 2020 rientra ad esempio nel campo degli eventi definibili come known unknowns o cigni grigi: vi erano stati esempi di pandemie simili in passato, i meccanismi di diffusione erano ampiamente conosciuti e alcune personalità note (tra cui Taleb e Gates) avevano ammonito circa i rischi di un simile evento, soprattutto in un contesto iperconnesso come quello attuale. Non era quindi un tema di conoscenza, ma di gestione del rischio: si sapeva che un evento del genere sarebbe potuto accadere anche se era difficile calcolarne la probabilità. Questo spiega i differenti tassi di incidenza del virus registrati tra i vari paesi come conseguenza delle diverse tecniche di gestione del rischio adottate. L’esempio più chiaro è quello di Singapore che, avendo capitalizzato l’esperienza SARS di qualche anno prima, aveva già predisposto un contigency plan che le ha consentito di ridurre al minimo gli impatti in termini di mortalità.

Gli eventi definiti come “unknown unknowns”, coincidono con quelli che Taleb definisce “cigni neri” e rientrano nel campo dell’imprevedibile e inquantificabile (in francese fortuit). Se 300 anni fa un meteorite avesse colpito la terra radendo al suolo una città avremmo parlato di cigno nero, perché un evento del genere era imprevedibile sulla base della conoscenza di allora. Oggi sarebbe considerato un cigno grigio.

La Nasa e i rischi dei viaggi nello spazio

Lo schema di ragionamento basato su “known unknowns” e “unknown unknowns” è la modalità operativa utilizzata dagli scienziati della NASA per valutare la rischiosità dei progetti spaziali. Pare infatti che sia stato proprio un ingegnere della NASA a presentare a Rumsfeld questo modello di pensiero.

In una presentazione del 2003 (Space Shuttle Return to Flight: The Safety Guy’s View) i responsabili della sicurezza della NASA illustravano le strategie per minimizzare i rischi delle missioni dello Space Shuttle.

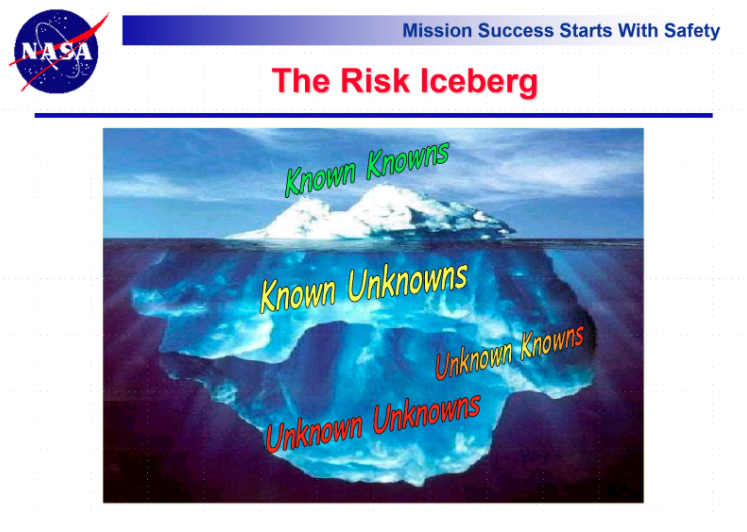

Utilizzando l’esempio di un iceberg (vedi figura 11 estratta dalla presentazione), i “known unknowns”, appena sotto la superficie dell’acqua, sono i possibili fallimenti dei sistemi esistenti, le incertezze insite nelle analisi di rischio e i potenziali errori dei modelli utilizzati per le previsioni.

Utilizzando l’esempio di un iceberg (vedi figura 11 estratta dalla presentazione), i “known unknowns”, appena sotto la superficie dell’acqua, sono i possibili fallimenti dei sistemi esistenti, le incertezze insite nelle analisi di rischio e i potenziali errori dei modelli utilizzati per le previsioni.

A maggiore profondità si trovano gli “unknown unknowns”, eventi incerti e imprevedibili derivanti da errate assunzioni dei modelli, da campi di ricerca non ancora esplorati e dall’operatività in condizioni (temperatura, velocità etc) non certificate.

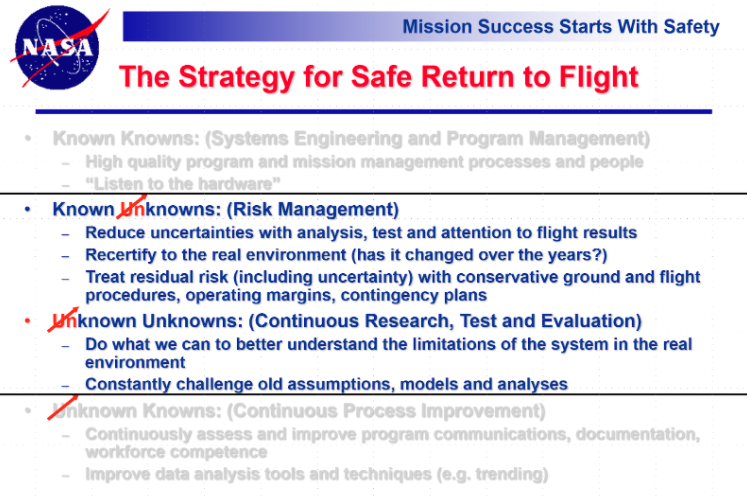

La parte più interessante è quella relativa alle strategie adottate dai tecnici della NASA per minimizzare i rischi (evidenziate nella figura 2).

Nel campo dei “known unknowns” vengono adottate tecniche di risk management: l’efficacia dei modelli attuali viene costantemente valutata sulla base dei nuovi dati di volo e anche il contesto operativo viene continuamente ricertificato. I rischi che non possono essere eliminati vengono affrontati adottando un approccio conservativo che prevede l’utilizzo di margini di sicurezza e contingency plans.

Contemporaneamente si cerca di trasformare i cigni neri in cigni grigi (da unknown unknowns a known unknowns) attraverso una continua attività di ricerca e sviluppo: si dedica grande attenzione alla comprensione dei limiti dei sistemi utilizzati e vengono continuamente messe in discussione le assunzioni e le analisi adottate nei modelli esistenti.

La gestione dei cigni neri e dei cigni grigi

L’approccio metodologico alla gestione del rischio adottato dalla NASA offre alcuni spunti interessanti di riflessione.

Innanzitutto occorre riconoscere che il colore del cigno dipende molto spesso dagli occhi di chi lo guarda: se non adottiamo i giusti modelli di interpretazione della realtà, ogni evento non comune ci apparirà travestito da cigno nero, saremo continuamente sorpresi e impreparati. Lo studio dei modelli mentali consente di trasformare molti cigni neri in cigni grigi, di passare da una gestione ex-post dell’imprevisto ad una gestione ex-ante del rischio. Se sappiamo che il mercato azionario può crollare più del 20% in un giorno, come accadde nel lunedì nero del 1987, un evento simile non è più un cigno nero ma diventa grigio. Sappiamo che potrà accadere di nuovo anche se non siamo in grado di prevederlo: dobbiamo quindi ragionare in termini di gestione del rischio. Il Covid è stato allo stesso tempo un cigno grigio per Singapore e il Giappone ed un cigno nero per molti altri paesi.

L’utilizzo dei corretti modelli di interpretazione della realtà è un fattore critico per il successo di qualsiasi azienda, in tutti i settori. Così come suggerito dai tecnici della NASA, occorre continuamente testare l’efficacia dei modelli utilizzati, valutare nel continuo i cambiamenti del contesto di riferimento e decidere ex-ante margini di sicurezza e piani di azione per i rischi che non possono essere eliminati.

In contesti di gioco molto incerti caratterizzati dai cigni neri, occorre essere consapevoli dei limiti di conoscenza dei modelli utilizzati ed investire importanti risorse in ricerca e sviluppo, attività di esplorazione che potrebbero portare ad individuare fenomeni che non sapevamo di non sapere restringendo di fatto il campo su cui può agire l’incertezza.

Per minimizzare gli impatti dei cigni neri, la struttura organizzativa deve essere snella e flessibile per potersi adattare velocemente e senza traumi ai cambiamenti del contesto. Puntare su processi estremamente pianificati, basati su un’intensa attività di previsione del futuro, rende particolarmente fragili nei confronti degli imprevisti.

Per gestire l’incertezza occorre privilegiare la preparazione rispetto alla previsione: come sostenuto da Louis Pasteur, “la fortuna premia le menti preparate”.

“La fortuna premia le menti preparate.” (Louis Pasteur)

1. L’iceberg del rischio. Slide estratta dalla presentazione Space Shuttle Return to Flight (The Safety Guy’s View), NASA , Osma Software Assurance Symposium, July 2003.

2. Le strategie per la gestione del rischio. Slide estratta dalla presentazione Space Shuttle Return to Flight (The Safety Guy’s View), NASA , Osma Software Assurance Symposium, July 2003.

Bibliografia

Gernert, Dieter. Ockham’s Razor and its Improper Use. Cognitive Systems, vol.7, no.2, 2009.

NASA. Space Shuttle Return to Flight (The Safety Guy’s View). Osma Software Assurance Symposium, July 2003.

Taleb, Nassim N. The Black Swan: The Impact of the Highly Improbable. Random House, 2010.